Imaginez le pire en Intelligence Artificielle.

Un algorithme biaisé surfacture un sous-ensemble de vos clients, déclenchant un scandale en termes de droits des consommateurs.

Une véhicule autonome de votre entreprise évite un accident et manœuvre pour sauver le conducteur, mais tue deux piétons.

C’est ainsi que débute le rapport réalisé par FICO sur l’Ethique de l’Intelligence Artificielle.

Les implications éthiques épineuses de l’arrivée de l’IA sont nombreuses et variées.

La plupart des entreprises qui adoptent les technologies d’IA ne sont pas confrontées à des choix de vie ou de mort. Mais elles risquent toutes de porter atteinte à leur réputation.

C’est la 2ème édition de l’enquête annuelle auprès de 100 responsables de données, d’analyses et d’IA réalisée pour la société d’analyse de données FICO.

Elle montre que de nombreuses entreprises accordent désormais plus d’attention à la question de l’éthique de l’IA.

En fait, 21% ont fait de l’éthique de l’IA un élément central de leur stratégies commerciales.

30% disent qu’ils le feront dans les 12 mois.

Mais les recherches montrent également qu’il y a peu de consensus sur les responsabilités des entreprises dans ce domaine.

«Je pense que l’on est maintenant beaucoup plus conscient que les choses vont mal», déclare Cortnie Abercrombie, fondatrice et PDG du collectif AI Truth.

Pratiquer l’éthique de l’Intelligence Artificielle et la gestion des risques dès la conception

Pour Jordan Levine, conférencier du MIT et associé chez Dynamic Ideas, fournisseur de formation en IA, les risques de réputation associés à une utilisation irresponsable de l’IA proviennent principalement d’instances non détectées de biais IA (Bias).

En tant que tel, il soutient que les entreprises ont besoin de processus rigoureux pour trouver, repérer et éliminer les biais tout au long du cycle de vie du modèle.

Il explique: «L’énoncé du problème est, en construisant un modèle, ai-je des sous-ensembles de ma population qui ont un taux d’exactitude différent de celui de la population mondiale plus large lorsqu’ils sont introduits dans le modèle?»

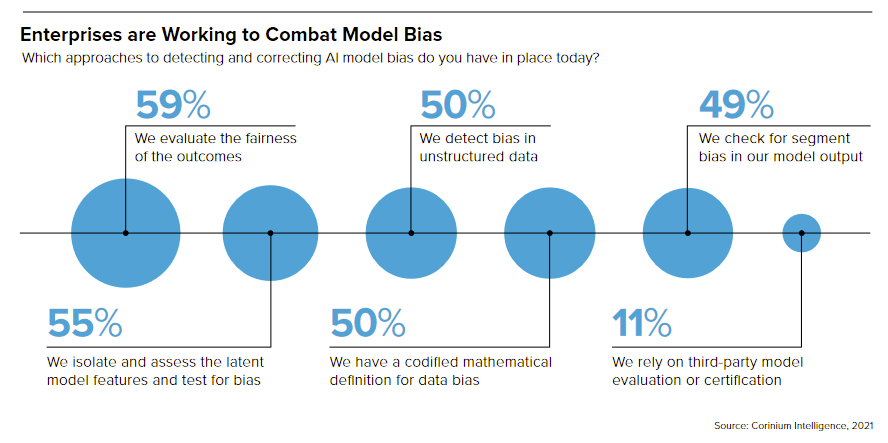

L’enquête montre que les entreprises utilisent une gamme d’approches pour éliminer les biais de l’Intelligence Artificielle au cours du processus de développement du modèle. Cependant, cela suggère également que peu d’organisations ont mis en place une série complète de freins et contrepoids.

L’évaluation de l’équité des résultats du modèle est la garantie la plus populaire dans le monde des affaires aujourd’hui.

59% des répondants affirmant qu’ils le font pour détecter les biais du modèle. La moitié disent avoir une définition mathématique codifiée du biais des données et vérifier activement le biais dans les sources de données non structurées. Pendant ce temps, 55% disent qu’ils isolent et évaluent les caractéristiques latentes du modèle pour les biais.

Seulement 22% des répondants disent que leur entreprise dispose d’un comité d’éthique de l’IA pour examiner les questions d’éthique et d’équité en matière d’IA.

Une personne sur trois a une équipe de validation de modèle pour évaluer les modèles nouvellement développés et seulement 38% disent avoir des étapes d’atténuation des biais de données intégrées dans les processus de développement de modèles.

En fait, la sécurisation des ressources pour garantir que les modèles d’Intelligence Artificielle sont développés de manière responsable reste un problème pour beaucoup. Seulement 54% des répondants disent qu’ils sont capables de le faire relativement facilement, tandis que 46% disent que c’est un défi.

En tant que tel, il semble que peu d’entreprises aient mis en place une approche «éthique dès la conception» qui garantirait qu’elles testent et corrigent régulièrement les problèmes de biais de l’IA au cours des processus de développement.

Quelques résultats de l’enquête

65% des entreprises interrogées ne peuvent pas expliquer comment les décisions ou les prédictions spécifiques à un modèle d’IA sont prises.

Seules 35% ont pris des mesures pour s’assurer qu’ils utilisent l’IA de manière transparente et avec une réelle responsabilité.

22% disent que leur entreprise dispose d’un comité d’éthique de l’IA pour examiner les questions d’éthique et d’équité en matière d’IA.

Les 78% restant sont mal équipés pour garantir que les implications éthiques de l’utilisation de nouveaux systèmes d’IA sont correctement prises en compte.

78% ont du mal à obtenir un soutien de la direction pour donner la priorité à l’éthique de l’IA et aux pratiques d’IA responsables.

Cela indique un manque de sensibilisation aux risques associés à une utilisation irresponsable de l’IA.

68% affirment que les processus dont ils disposent pour garantir que les projets d’IA sont conformes à la réglementation sont «inefficaces».

46% les décrivent comme «très inefficaces». Cela souligne la nécessité d’investir davantage dans ce domaine dans la plupart des entreprises.

77% conviennent que la technologie AutoML pourrait être utilisée à mauvais escient. Les cadres qui s’inquiètent de l’utilisation abusive de l’IA doivent s’assurer que les résultats des modèles sont explicables et que le personnel sait comment les modèles prennent leurs décisions.

90% conviennent que les processus inefficaces de surveillance des modèles représentent un obstacle à l’adoption de l’IA dans leurs entreprises.

Cela suggère que presque toutes les entreprises pourraient bénéficier de l’amélioration de leurs processus d’opérationnalisation de modèle.

Pour en savoir plus :

Le rapport de FICO (en anglais)

|