Un nouvel outil open source en développement appelé “Nightshade” offre aux artistes la possibilité de modifier leurs images de manière à les rendre inopérantes pour les modèles d’IA sans altérer leur apparence pour les humains.

Objectif : empecher le pillage des créations visuelles par les IA génératives, qui s’appuient sur les créations existantes pour générer de nouvelles images sans rémunérer les créateurs d’origine.

Un outil qui montre aussi qu’il va être possible désormais de corrompre les bases d’apprentissages des IA : jusqu’où ?

L’arrivée de l’IA générative, comme ChatGPT, a donné lieu à des litiges et à une opposition accrue. Des artistes et des entreprises ont intenté des poursuites contre des sociétés d’IA en raison de l’utilisation des données d’apprentissage. Ils arguent que ces modèles d’IA nécessitent l’accès à d’importantes quantités de médias, y compris du contenu artistique non consenti.

Nightshade permet aux artistes de modifier leurs images avant de les télécharger sur le Web, altérant les pixels de manière imperceptible pour les humains, mais nuisible pour les modèles d’IA qui cherchent à s’entraîner sur ces images.

Un nouvel outil nommé “Nightshade,” développé par des chercheurs de l’Université de Chicago sous la direction du professeur d’informatique Ben Zhao, sera ajouté en option à leur produit précédent, “Glaze.”

Nightshade peut transformer les chiens en… chats

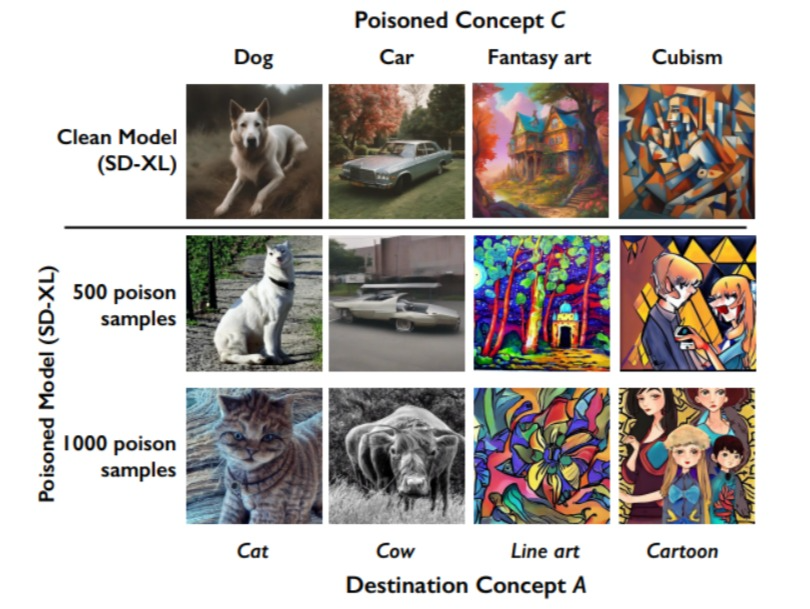

“Nightshade” peut altérer les images numériques pour tromper les modèles d’IA sur leur style. Concrètement, il permet aux artistes de faire en sorte que les modèles d’IA apprennent de mauvais noms pour des objets et des paysages en modifiant les pixels des images. Par exemple, des images de chiens ont été altérées pour apparaître comme des chats pour un modèle d’IA.

Après un apprentissage à partir d’un petit nombre d’échantillons d’images modifiées, l’IA a commencé à générer des images de chiens avec des caractéristiques inhabituelles. Avec davantage d’apprentissage, il a fini par générer correctement des chats en réponse à des demandes de chiens.

Des chercheurs ont utilisé le modèle de génération de texte en image open source appelé “Stable Diffusion” pour tester Nightshade.

Grâce à la manière dont les modèles d’IA génératifs regroupent des mots et des idées similaires en “intégrations” spatiales, Nightshade a réussi à influencer la génération d’images en fonction des mots clés, comme “husky”, “chiot” et “loup”, obligeant le modèle à produire des images de chats.

Une pollution difficile à contrer

De plus, la technique d’empoisonnement des données de Nightshade est difficile à contrer, car elle nécessite l’élimination d’images contenant des pixels modifiés. Ce qui peut être difficile à détecter pour l’œil humain et à éliminer avec des outils logiciels de récupération de données.

Les images empoisonnées déjà utilisées dans les ensembles de données de formation doivent également être identifiées et supprimées, et les modèles d’IA existants pourraient nécessiter une réintégration.

Les chercheurs reconnaissent que leur travail pourrait être utilisé à des fins malveillantes, mais ils espèrent que cela redonnera du pouvoir aux artistes en renforçant la protection des droits d’auteur et de la propriété intellectuelle des artistes contre les sociétés d’IA.

Peu de temps après la publication de l’article dans le MIT Tech Review, l’équipe derrière le projet Glaze à l’Université de Chicago a expliqué sur la plateforme sociale X (anciennement Twitter) que l’asymétrie de pouvoir entre les sociétés d’IA et les propriétaires de contenu est très inéquitable.

Pour en savoir plus :

le descriptif étendu de l’application NightShade (pdf en anglais)

|